2024-04-28 11:01

2024-04-28 11:01

韩国团队打造IDM-VTON扩散模型:实现AI一键试衣,让奥特曼、黄仁勋等大佬换穿淘宝文化衫

以下文章来自于丨机器之心

AI 帮你来试衣,想穿什么款式一键搞定。

精准捕捉服装细节,衣服纹理、图案、缝线等属性高度还原:

即使是在户外,AI 试衣也能准确展示试穿效果,保持较高质量的输出:

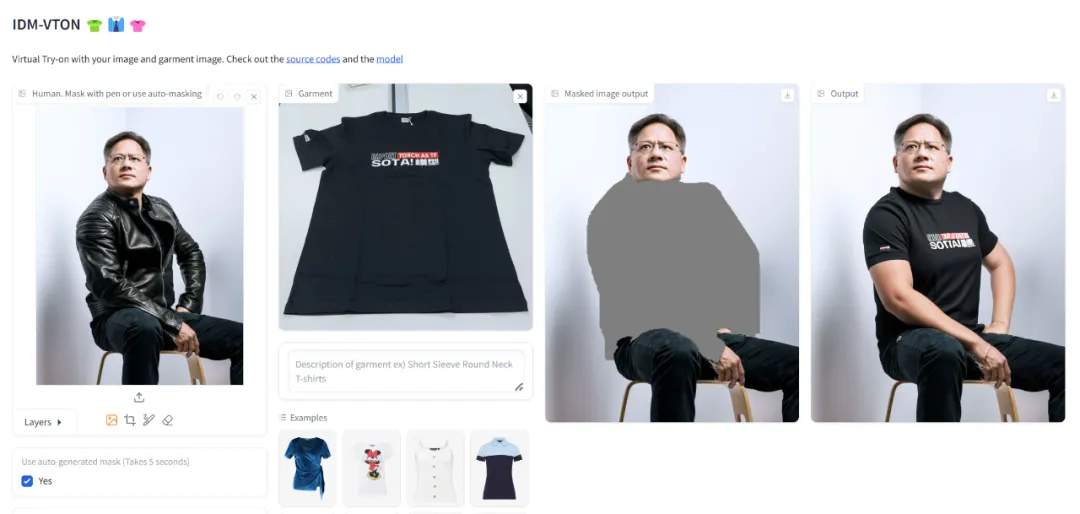

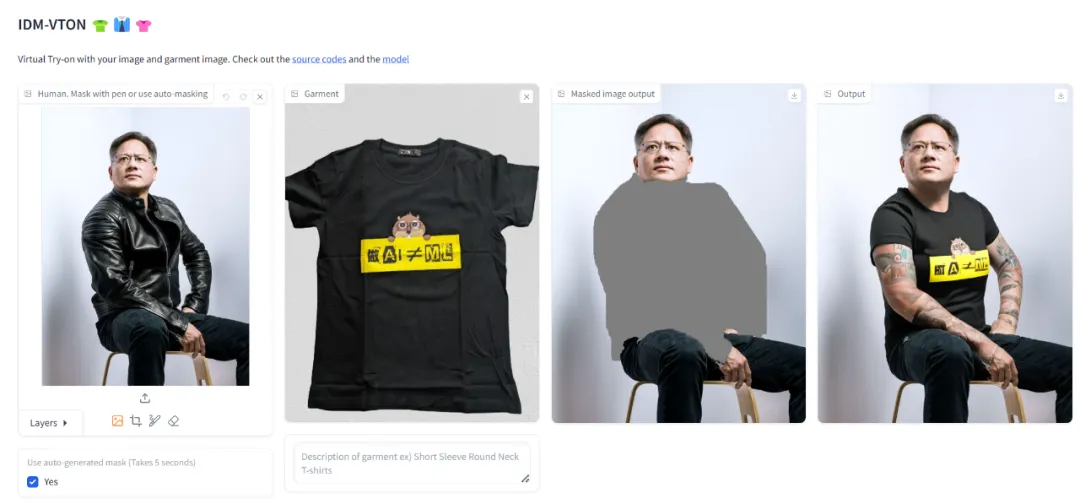

人物坐立姿势对衣物有遮挡,AI 也会毫无破绽的实现一键换衣,高度保持服装细节的一致性:

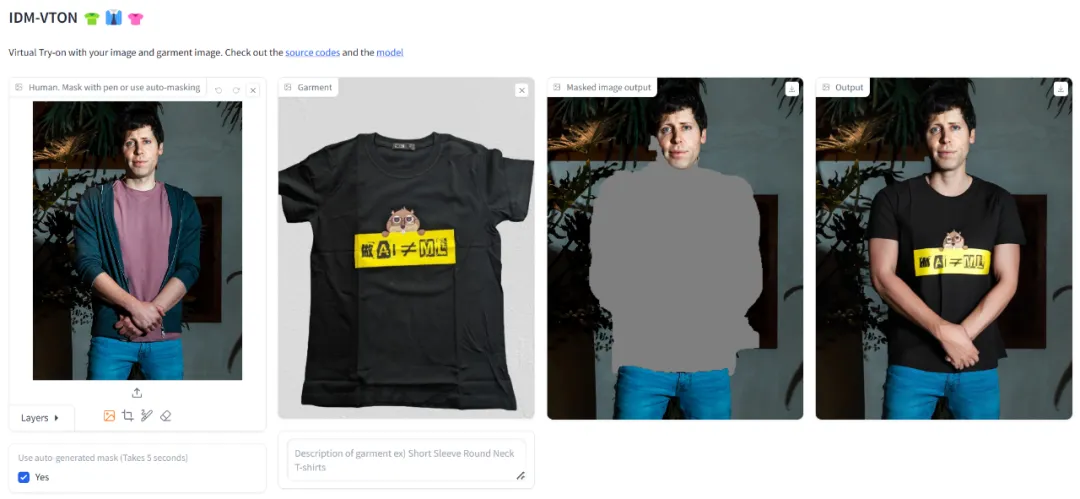

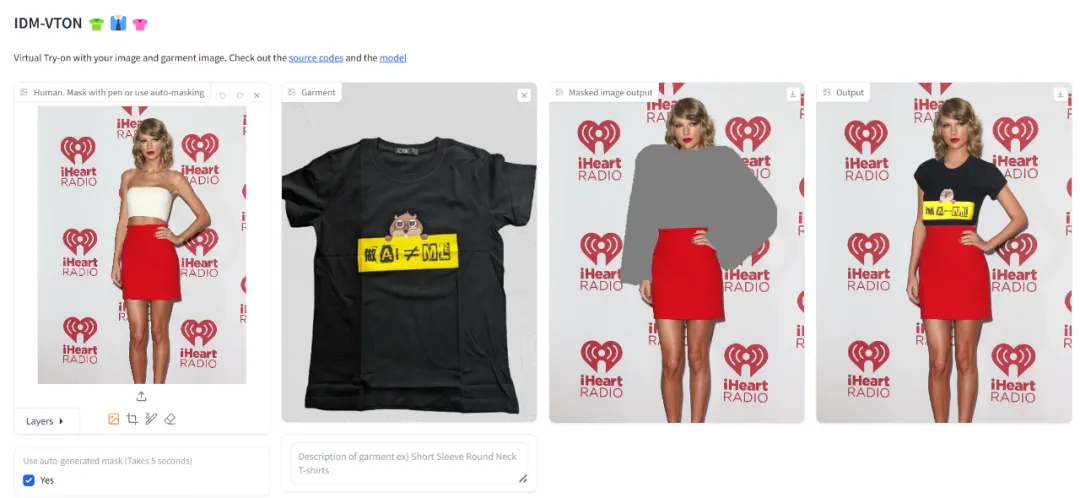

既然 demo 演示这么厉害,那试试让黄仁勋、奥特曼、霉霉等名人穿上机器之心的文化衫,出来的效果会怎么样呢?

试用了几轮下来,换装效果的确不错,但也有一些瑕疵,比如换装后有时会出现大花臂、衣服上的字体没有很好地还原、手部变形。

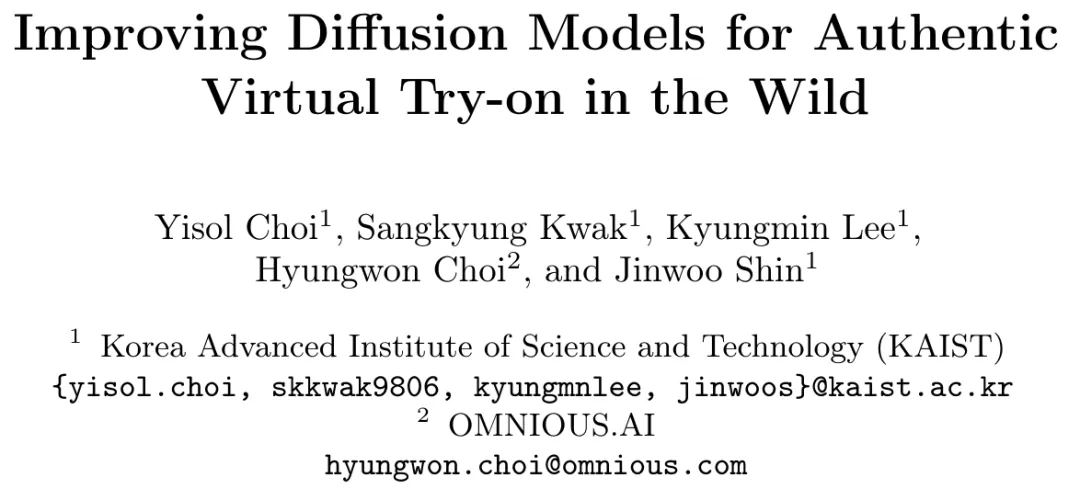

上面展示的虚拟试衣技术由韩国科学技术院(KAIST) 、OMNIOUS.AI 共同打造,他们提出了一种名为「IDM-VTON」的新型扩散模型,该技术在提高服装保真度的同时,还能生成真实的视觉效果。

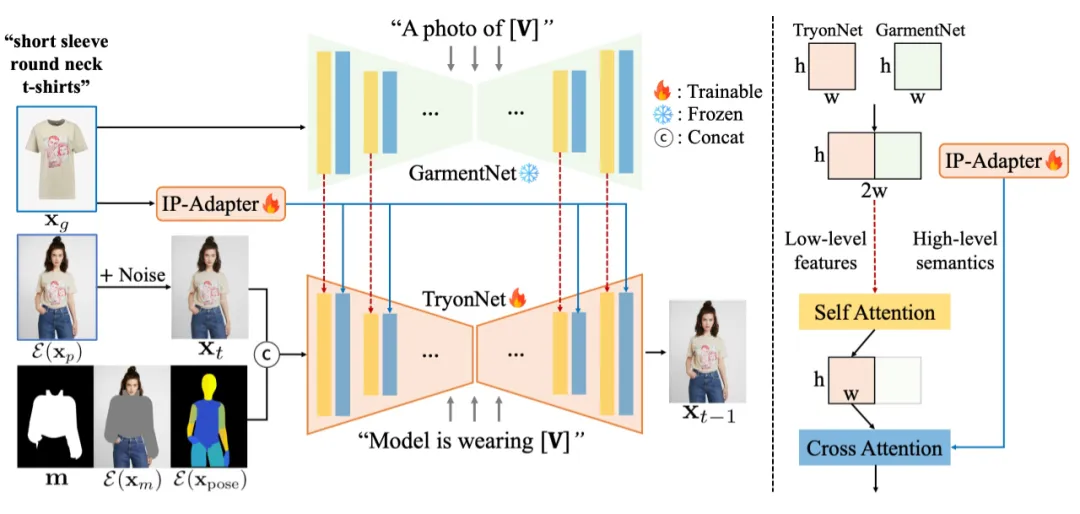

IDM-VTON 整体 pipelne 如下图左所示:IDM-VTON 包括(1)TryonNet 用于处理人物图像;(2)图像提示适配器(IP-Adapter)用于编码服装图像的高级语义;(3)GarmentNet 用于编码低级特征。

在 UNet 输入中,本文将人物图像潜在的噪声潜在与分割掩码、掩码图像和 DensePose 进行了拼接。本文还提供了服装的详细说明(例如,[V]:短袖圆领 T 恤),然后这些说明作为 GarmentNet 和 TryonNet 的输入提示。

注意力模块细节如下图右所示:

TryonNet 和 GarmentNet 的中间特征被连接起来并传递到自注意力层,并使用输出的前半部分(即来自 TryonNet 的部分)。然后通过交叉注意力层将输出与来自文本编码器和 IP-Adapter 的特征融合。此外,本文还对 TryonNet 和 IP-Adapter 模块进行微调,同时冻结其他组件。

最后,我们再展示一下 IDM-VTON 的其他效果。

多人试穿同一件衣服:结果显示 IDM-VTON 可以生成高保真图像,识别服装细节。

IDM-VTON 和其他方法的比较结果可以看出,IDM-VTON 能够生成真实的图像并能够保留服装的细粒度细节。

了解更多内容,请参考原论文。

论文地址:https://arxiv.org/pdf/2403.05139.pdf

论文主页:https://idm-vton.github.io/

论文标题:Improving Diffusion Models for Authentic Virtual Try-on in the Wild

想体验这款最新的AI大模型可以访问Hugging Face网站:

近期文章

更多