2024-03-18 11:29

2024-03-18 11:29

3140亿参数量,登顶「地表最强开源大模型」!马斯克旗下xAI正式开源Grok 1.0大模型

当地时间3月17日晚间,马斯克信守诺言,赶在本周的最后时刻开源旗下AI大模型。

作为要重锤OpenAI「闭源搞钱」的道德高地,马斯克十分器重此次开源。

在2月29日,马斯克以OpenAI未能“信守成立初衷的开源政策”为理由,将后者告上法庭。

他旗下的AI研究机构xAI,几个小时前在GitHub上正式发布了Grok-1大模型的相关开源代码。整个大模型的数据权重规模约为300GB。

官方很霸气,直接贴了一条磁力链接。🔗

据专家分析,其参数量达到了3140亿,远超OpenAI一年多以前推出的GPT-3.5大模型的1750亿规模。

如无意外,这将是世界上迄今参数量最大的开源LLM大语言模型,并遵照Apache 2.0开源协议开放模型的权重和架构。

根据xAI官方的说明,Grok-1是马斯克在2023年7月12日成立的这家AI公司推出的首个「自研大模型」。

官方特别强调,这是他们自己从头训练的大模型——Grok-1没有针对特定的应用或者测评排行榜进行模型微调。

这款大模型在2023年11月上线推特(X)平台公测,需要开通会员使用。

换句话说,老马的团队大约花了一个季度多一点的时间,搞出了地表最大规模的开源大模型。

此前我们曾经发文介绍过这款模型的基本概况,点击链接复习:

马斯克即将开源的大模型Grok AI什么水平?V1.0版本性能超GPT-3.5、LLaMA2-70B,本月将推V1.5版本

根据公开的测评榜单,Grok-1在多个测试平台上的性能表现显著,超越了LLaMA2-70B和GPT-3.5。然而,在与Claude 2和GPT-4的比较中,仍存在一定差距。

据EVA了解,Grok-1是一个当下普遍采取混合式“专家大模型”,Mixture-of-Experts,缩写MOE。

这种MOE架构重点在于提高大模型的训练和推理效率。形象地理解,大模型并非万能解药,MOE就像把各个领域的“医疗专家”集合到了一起,遇到对应的垂类“疑难杂症”便派发给不同专项领域的“门诊专家”解答,最后汇总结论,提升模型的执行效率。

决定每个领域的专家做什么的系统,被称为“门控网络”机制,该机制的执行效率决定了“专家模型”输出内容的品质。此前几个月,GPT-4的“专家模型”多次出现疑似智商下降、回复内容不够充分等问题。

言归正传,此次略显不足的是,xAI并没有同步放出Grok-1的具体测评成绩,我们未能窥见Grok位于各个测评榜单的研究分析数据,因此不易客观了解Grok模型的真实水平。🤐

😅而隔壁家谷歌Gemini发布的时候,测评榜可谓“秒天秒地秒空气”。

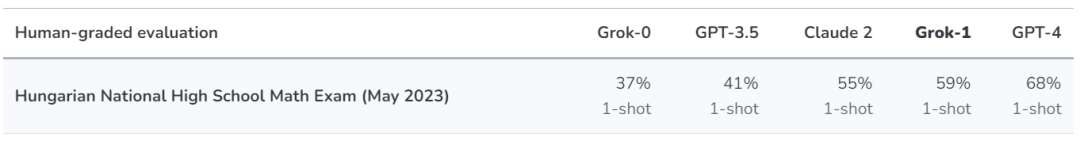

不过我们可以参考一项三方测评结果。

借由去年5月的2023年匈牙利全国高中数学期末考试题,Grok与其他几款主流的大模型进行了人工评分。

如果以匈牙利方面的评级规范,Grok以C级(59%)通过本项考试,成绩合格。知名大模型Claude 2取得了接近的成绩(55%),而GPT-4则以68%的成绩获得了B级,表现最佳。

单就这一次测试结果来看,Grok-1领先Claude 2、GPT-3.5等主流模型。

xAI表示,他们并没有为这项测试特别准备或调整模型。

最后看一个花边消息——

就在xAI官方放出开源代码后,Grok官号与老马进行互动,留下一句:「WEIGHTS IN BIO」,意思是“我们在世界上有了举足轻重的影响力”。

ChatGPT的官号很快在马斯克的推特(X)账号下方进行了互动:「你偷了我的笑话。」

马斯克并不示弱,直接反击——「请告诉我,OpenAI的“Open”之处。」

Alright…遗憾的是,xAI方面并没有公开关于Grok大模型的训练方式以及技术研究方法。各界仍然十分期待老马持续加大开源力度,继续嘲讽OpenAI。

鉴于马斯克对开源事业的积极态度,AI开发者们已经在期待后续的开源版本。

最后,在开源Grok-1之后,马斯克的新一代模型Grok-1.5.也会在近期发布。

Grok-1开源项目地址:

🔗相关阅读: